СТАТЬИ

SEO-дайджест: май 2010 г.

Bing совершенствуется в обработке 301-ых редиректов

Мы уже не раз писали о том, что у Bing есть проблемы с 301-ыми редиректами, которые, к счастью, он начал постепенно решать. Похоже, что в мае он сделал еще один шаг на пути к этому.

На Bing Help один вебмастер рассказал о том, что, наконец, разрешился вопрос, связанный с обработкой 301-ой переадресации на его сайте. Более того, бингер Бретт Юнт (Brett Yount) сам подтвердил о том, что в этом направлении они значительно продвинулись.

Обсуждение на Bing Help.

Безопасность хостинга превыше всего!

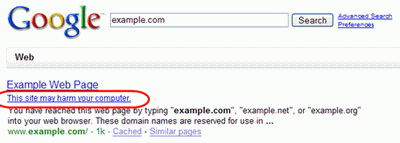

Практически каждый сурфер хоть раз сталкивался с тем, что в поисковых результатах находил предупреждение не кликать на тот или иной сайт, так как он может навредить компьютеру. Вирусы становятся все более серьезной проблемой для SEO-индустрии, поскольку такие уведомления однозначно могут уменьшить количество трафика. К сожалению, с каждым днем они встречаются все чаще и чаще.

Практически каждый сурфер хоть раз сталкивался с тем, что в поисковых результатах находил предупреждение не кликать на тот или иной сайт, так как он может навредить компьютеру. Вирусы становятся все более серьезной проблемой для SEO-индустрии, поскольку такие уведомления однозначно могут уменьшить количество трафика. К сожалению, с каждым днем они встречаются все чаще и чаще.

Частыми мишенями для хакерских атак становятся дешевые хостинг-компании. На Sphinn один вебмастер ссылается на статью, в которой приводится конкретный пример – компания GoDaddy's. Этот хостинг-провайдер подвергается нападкам хакеров чересчур часто. Другой пример - Network Solutions, которого взламывают еженедельно!

Поэтому всегда важно помнить, что даже самые лучшие позиции в поиске не могут гарантировать хороший трафик, если безопасность вашей хостинг-компании оставляет желать лучшего!

Обсуждение на Sphinn.

В каких случаях Google предпочитает 302-ые редиректы?

На Google Webmaster Help появилась дискуссия по поводу редиректов. Когда вебмастер хочет средиректить одну веб-страницу на другую, то в основном он пользуется постоянной 301-ой переадресацией. Но есть один случай, когда надо использовать временное 302-ое перенаправление. Вот что по этому поводу говорит гуглер ДжонМу:

Обсуждение на Google Webmaster Help.

Обновляйте Robot.txt за 24 часа до того, как добавите в него данные о новом контенте

Гуглер ДжонМу сообщил очень интересный факт. Например, однажды вы заблокировали от индексации какую-то директорию в robots.txt. Затем вы решили добавить новый контент в эту директорию, чтобы Google его проиндексировал. Как оказалось, поскольку Google кэширует ваш robots.txt файл, нужно сделать так, чтобы Google обновил его за 24 часа до желаемой даты обновления контента в заблокированной директории.

Обсуждение на WebmasterWorld.

Удаление URL-адресов из XML Sitemap никак не влияет на ранкинг

На Cre8asite Forums появилась дискуссия по поводу удаления URL-адресов из XML Sitemap. Ходят слухи, будто при их удалении из файла происходит их удаление из индекса Google. Но как оказалось, это неправда.

XML Sitemap является лишь дополнительным инструментом для Google при обнаружении вашего контента. Но вовсе необязательно, что при индексации ресурса Google будет руководствоваться только им. Как сказал сам гуглер ДжонМу, Google не удаляет URL-адреса из индекса, если их нет в файле Sitemap.

Обсуждение на Cre8asite Forums.

Мы уже не раз писали о том, что у Bing есть проблемы с 301-ыми редиректами, которые, к счастью, он начал постепенно решать. Похоже, что в мае он сделал еще один шаг на пути к этому.

На Bing Help один вебмастер рассказал о том, что, наконец, разрешился вопрос, связанный с обработкой 301-ой переадресации на его сайте. Более того, бингер Бретт Юнт (Brett Yount) сам подтвердил о том, что в этом направлении они значительно продвинулись.

Обсуждение на Bing Help.

Безопасность хостинга превыше всего!

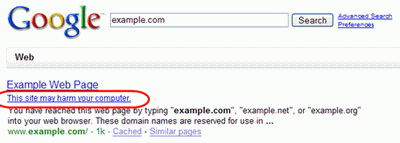

Практически каждый сурфер хоть раз сталкивался с тем, что в поисковых результатах находил предупреждение не кликать на тот или иной сайт, так как он может навредить компьютеру. Вирусы становятся все более серьезной проблемой для SEO-индустрии, поскольку такие уведомления однозначно могут уменьшить количество трафика. К сожалению, с каждым днем они встречаются все чаще и чаще.

Практически каждый сурфер хоть раз сталкивался с тем, что в поисковых результатах находил предупреждение не кликать на тот или иной сайт, так как он может навредить компьютеру. Вирусы становятся все более серьезной проблемой для SEO-индустрии, поскольку такие уведомления однозначно могут уменьшить количество трафика. К сожалению, с каждым днем они встречаются все чаще и чаще. Частыми мишенями для хакерских атак становятся дешевые хостинг-компании. На Sphinn один вебмастер ссылается на статью, в которой приводится конкретный пример – компания GoDaddy's. Этот хостинг-провайдер подвергается нападкам хакеров чересчур часто. Другой пример - Network Solutions, которого взламывают еженедельно!

Поэтому всегда важно помнить, что даже самые лучшие позиции в поиске не могут гарантировать хороший трафик, если безопасность вашей хостинг-компании оставляет желать лучшего!

Обсуждение на Sphinn.

В каких случаях Google предпочитает 302-ые редиректы?

На Google Webmaster Help появилась дискуссия по поводу редиректов. Когда вебмастер хочет средиректить одну веб-страницу на другую, то в основном он пользуется постоянной 301-ой переадресацией. Но есть один случай, когда надо использовать временное 302-ое перенаправление. Вот что по этому поводу говорит гуглер ДжонМу:

«302-ой редирект следует использовать, если переадресация происходит с корневого URL-адреса на какую-то страницу сайта (пример, с «/» на «/sites/bursa/»). Этот один их тех случаев, когда лучше применить 302-ой редирект, а не 301-ый.»

Обсуждение на Google Webmaster Help.

Обновляйте Robot.txt за 24 часа до того, как добавите в него данные о новом контенте

Гуглер ДжонМу сообщил очень интересный факт. Например, однажды вы заблокировали от индексации какую-то директорию в robots.txt. Затем вы решили добавить новый контент в эту директорию, чтобы Google его проиндексировал. Как оказалось, поскольку Google кэширует ваш robots.txt файл, нужно сделать так, чтобы Google обновил его за 24 часа до желаемой даты обновления контента в заблокированной директории.

Обсуждение на WebmasterWorld.

Удаление URL-адресов из XML Sitemap никак не влияет на ранкинг

На Cre8asite Forums появилась дискуссия по поводу удаления URL-адресов из XML Sitemap. Ходят слухи, будто при их удалении из файла происходит их удаление из индекса Google. Но как оказалось, это неправда.

XML Sitemap является лишь дополнительным инструментом для Google при обнаружении вашего контента. Но вовсе необязательно, что при индексации ресурса Google будет руководствоваться только им. Как сказал сам гуглер ДжонМу, Google не удаляет URL-адреса из индекса, если их нет в файле Sitemap.

Обсуждение на Cre8asite Forums.

обсудить (0)